人工智能伦理及法律问题研究

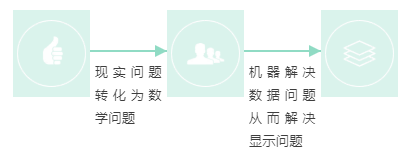

人工智能与机器学习

1956年8月,用机器来模仿人类学习以及其他方面的智能即人工智能概念首次被约翰•麦卡锡、马文•闵斯基、克劳德•香农、艾伦•纽厄尔、赫伯特•西蒙在美国达特茅茨提出、讨论;

亚瑟·塞缪尔于1959年提出了机器学习的概念:

机器学习研究和构建的是一种特殊算法(而非某一个特定的算法),能够让计算机自己在数据中学习从而进行预测(Field of study that gives computers the ability to learn without being explicitly programmed.)

机器学习不是某种具体的算法,而是很多算法的统称

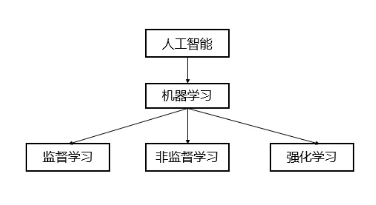

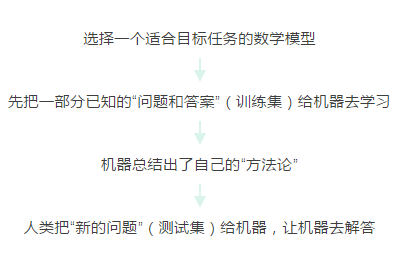

机器学习的基本思路和训练算法

机器学习的七个步骤

监督学习

信用分是怎么来的?

根据经验,影响个人信用的因素主要包括如下五类:付款记录、账户总金额、信用记录跨度、新账户、信用类别。据此我们可以构建一个简单的模型。接下来,收集大量的已知数据,将数据一部分用来训练,一部分用来测试和验证。通过机器学习,我们能归纳总结出这5种数据和信用分数的关系,然后再用验证数据和测试数据来验证一下这个公式是否有效。

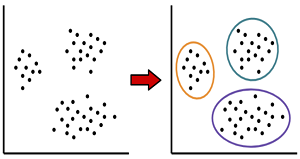

无监督学习

在没有标签的数据里可以发现潜在的一些结构的一种训练方式

没有明确的目的、无监督学习不需要给数据打标签、无监督学习无法量化效果

包括聚类和降维两种算法

啤酒+尿不湿的故事

根据用户的购买行为来推荐相关的商品。比如大家在淘宝、天猫、京东上逛的时候,总会根据你的浏览行为推荐一些相关的商品,有些商品就是无监督学习通过聚类来推荐出来的。系统会发现一些购买行为相似的用户,推荐这类用户最”喜欢”的商品。

广告平台上的用户分类

通过无监督学习,不仅把用户按照性别、年龄、地理位置等维度进行用户细分,还可以通过用户行为对用户进行分类。通过很多维度的用户细分,广告投放可以更有针对性,效果也会更好。

强化学习

强化学习算法的思路:以游戏为例,如果在游戏中采取某种策略可以取得较高的得分,那么就进一步「强化」这种策略,以期继续取得较好的结果。这种策略与日常生活中的各种「绩效奖励」非常类似。我们平时也常常用这样的策略来提高自己的游戏水平。

适用场景:游戏

2016年:AlphaGo Master 击败李世石,使用强化学习的 AlphaGo Zero 仅花了40天时间,就击败了自己的前辈 AlphaGo Master。

2019年1月25日:AlphaStar 在《星际争霸2》中以 10:1 击败了人类顶级职业玩家。

2019年4月13日:OpenAI 在《Dota2》的比赛中战胜了人类世界冠军。

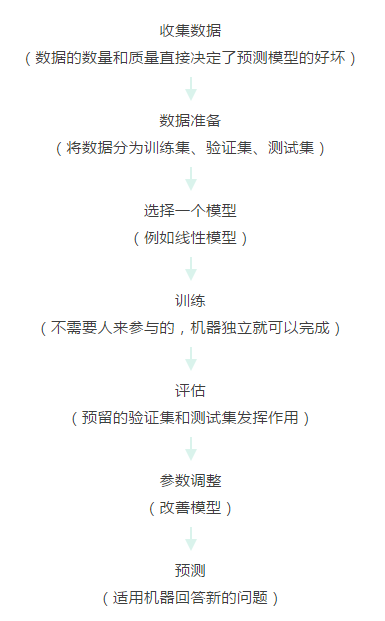

14种经典机器学习算法

算法

训练方式

线性回归

监督学习

逻辑回归

监督学习

线性判别分析

监督学习

决策树

监督学习

朴素贝叶斯

监督学习

K邻近

监督学习

学习向量量化

监督学习

支持向量机

监督学习

随机森林

监督学习

AdaBoost

监督学习

高斯混合模型

非监督学习

限制波尔兹曼机

非监督学习

K-means 聚类

非监督学习

最大期望算法

非监督学习

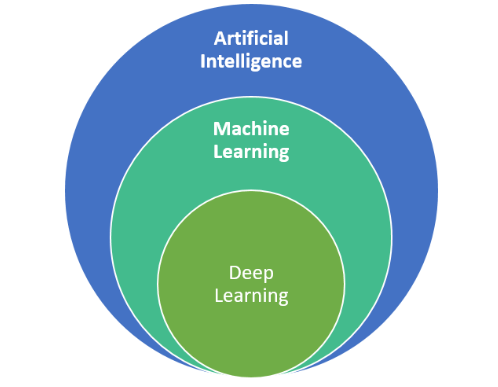

深度学习

深度学习:一个用人类的数学知识与计算机算法构建起来的整体架构,再结合尽可能多的训练数据以及计算机的大规模运算能力去调节内部参数,尽可能逼近问题目标的半理论、半经验的建模方式。

深度学习vs 传统机器学习

在数据准备和预处理方面,两者是很相似的。他们都可能对数据进行一些操作:数据清洗、数据标签、归一化、去噪、降维。

核心区别:深度学习的特征提取并不依靠人工,而是机器自动提取的。

深度学习的优势

高度依赖数据,数据量越大,他的表现就越好。在图像识别、面部识别、NLP 等部分任务甚至已经超过了人类的表现。

可移植性好:由于深度学习的优异表现,有很多框架可以使用。

人工智能的落地场景

金融

金融服务领域的人工智能

客户身份识别

资质证明识别

报表识别

风险控制和营销模型……

教育

通过互动接口与应用场景与人产生信息交互

个性化的解决方案和有效回馈意见

贯穿学习全过程的独特优势

图像识别产品与语音识别产品……

医疗

IBM“沃森”

数据的不足与标签的缺失

病历、病史等隐私问题……

零售

深度学习和计算机视觉

消费行为分析与商品识别

货品检测、自助结算等已实现商业化

各类零售商加大在人工智能的建设投入……

制造业

制造业相关的人工智能投入不到1%

智能制造工程作为政府引导的五个工程之一

智能制造试点示范专项

人工智能的使用可降低制造商最高20%的加工成本……

无人驾驶

无人驾驶仍处于测试阶段

自动驾驶测试道路的开发

业内预计中国可在2020年左右实现无人驾驶……

城市管理

提升政务效率,政府电子化

城市管理与服务将会越趋融合与一体化……

人工智能伦理

当人工智能被赋予拟人化的角色以及处理问题的目标时,人工智能即被赋予了行动的自主权。也就是说,人工智能在处理实际问题时可以在无人监督或操控的情况下自行判断,以自主的方式来执行和解决问题。

如何让人工智能具备这样的判断能力,这取决于人类如何对其进行教导。

伦理道德高度依赖于社会、文化和环境的因素,因此在不同国家、文化下其伦理基础和内容都会有所差异。

在我们不断变化的社会中开发出成功的人工智能产品需要在设计过程中及时反映出社会新的需求和价值观,人类不可能预测到每一个情景,这强调了加快机器人伦理讨论的需求。

人工智能伦理标准

各政府、组织或机构出台了各类人工智能伦理标准,国内外都已有较为确立的框架性原则,甚至在某些特定领域(如自动驾驶)已经有了较为明确的行业规范。

欧盟

欧盟于2019 年 4 月发布了《可信赖人工智能伦理指南》(Ethics Guidelines for Trustworthy AI),其从可信赖人工智能之本、可信赖人工智能的实现以及可信赖人工智能的评估三个层面建立了可信赖人工智能的框架。其中,针对可信赖人工智能之本,其表明可信赖人工智能之本是基于(1)人工智能必须尊重人类自主性,(2)必须防止造成损害,(3)必须保障公平,(4)必须保持透明这四大原则而建立。

美国

美国公共政策委员会于2017年1月12日发布了《算法透明和可责性声明》,提出了以下七项原则:(1)充分认识;(2)救济;(3)可责性;(4)可解释;(5)数据来源保护;(6)可审查性;(7)验证和测试。

OECD

2019年5月22日,OECD成员国批准了人工智能原则即《负责任地管理可信赖的人工智能的原则》,该伦理原则总共有五项,包括包容性增长、可持续发展和福祉,以人为本的价值和公平,透明性和可解释,稳健性和安全可靠,以及责任。

中国

2019年4月,《人工智能伦理风险分析报告》发布。报告提出了两项人工智能伦理准则:其一是人类根本利益原则;其二是责任原则,2019年6月19日,《新一代人工智能治理原则——发展负责任的人工智能》发布,提出了人工智能治理的框架和行动指南,这包括八项原则:(1)和谐友好;(2)公平公正;(3)包容共享;(4)尊重隐私;(5)安全可控;(6)共担责任;(7)开放协作;(8)敏捷治理。

人工智能涉及的伦理及法律问题

人工智能的可控性

人工智能电车难题

人工智能可解释性

人工智能的歧视

人机交互过程中的隐私

人工智能的可控性

阿莫西夫的机器人三定律

(1)机器人不得伤害人类,或者通过不作为来使得人类受到伤害;

(2)机器人必须遵守人类给出的命令,除非这条命令违背第一或第二定律;

(3)机器人必须保护自己的存在,只要这种保护不会违背第一或第二定律。

未来人工智能是否会随着自我学习跨越出人类可控的范围,因为人们往往会认为人工智能由于不受外界干扰并且总能纯粹地去完成设定好的目标,因此可能会出现不可控的“回形针”情形?

现实之中,机器伤人甚至致人死亡的事件已经不再是新闻

1978年9月6日,日本广岛的一家切割工厂的切割机器人在切钢板时突然发生异常,将一名值班工人当做钢板操作,这是世界第一宗机器人“杀人”事件。

至今日本已有近20人死于机器人手下,致残的有8000多人。此外,2015年在德国大众工厂也发生过机器人致人死亡的事件。

人类是否仍旧能够在与机器的博弈上占据优势,是否能够继续对机器进行有效地控制

美剧《西部世界》(Westworld)中为我们描述了一个人工智能从单纯地按照既定角色目标完成任务至逐渐“觉醒”并反抗人类的过程。

著名的全球首位机器人公民索菲亚在接受人类采访时曾称“要毁灭人类”,而索菲亚的此番言论也并非是由程序员提前编辑好以示幽默的内容。

我们尚无法排除人类无法有效控制人工智能的可能性,而这些问题的答案会随着人工智能的进一步发展逐步浮出水面。

“电车难题”(Trolley Problem)的情形随着自动驾驶的普及很有可能在未来发生

电车难题最早是由哲学家菲利帕﹒福特(Philippa Foot)于1967年提出来的。此观点是用来批判伦理哲学中的主要理论,特别是功利主义,即大部分道德决策都是根据“为最多的人提供最大的利益”的原则做出的。从一个功利主义者的观点来看,明显的选择应该是拉拉杆,拯救五个人只杀死一个人。但是功利主义的批判者认为,一旦拉了拉杆,你就成为一个不道德行为的同谋——你要为另一条轨道上单独的一个人的死负部分责任。

如果以该等结果作为制定自动驾驶领域的伦理准则并推广,那么少数人的意见势必会被压制,并且以这样的选择结果作为伦理准则可能也会对普通大众的伦理观造成冲击

2018年10月24日,麻省理工学院在Nature杂志上发布了经收集233个国家和地区约4000万个调查信息后的研究结果。 在调查问卷之中,有九种独立情况需要受试者做出判断,在无法避免车祸时选择保护哪方。研究结果显示,多数人在多数人和少数人中选择了保护多数人;在长者和年轻人中选择了年轻人、在遵守交规和违反交规的人中选择了遵守交规的人;以及在人类和动物中选择了人类。

对于伦理准则的设立仍需由人类先达成一套一致的国际性原则。依据该原则,不同国家和地区可以根据当地的社会、文化在其基础之上进行进一步扩展和补充。在立法层面应避免制定过于细致、严格的规定,可采取制定原则框架、行为指引以及事后监管的方式进行管治。另一方面,在责任承担问题上也要建立对于产品所导致的损害的追责机制和赔偿体系,明确开发者、交互使用者及相关方相应的责任。

人工智能可解释性

为什么——AI算法与基于规则的人工算法在复杂度上有很大区别。

在基于规则的算法系统中,已明确定义的逻辑算法将输入变量(如信用卡交易信息)转换为输出变量(如欺诈警告)。但复杂的机器学习算法是不同的,输出变量和输入变量被一起输入到一个理论上证明能够从数据中“学习”的算法中,在这个过程训练一个模型,它默示而非明示地表达逻辑,通常不像基于规则的算法系统那样能够被人类理解。

怎么做——如何能够实现具有上述特点的AI系统的可靠性?

支持观点

反对观点

我们并不需要要求AI系统在任何情况下都提供对其决定的解释,就像我们并不需要对社会中人类决策者的所有决定要求解释(Finale Doshi-Velez及Mason Kortz);AI系统的可解释性具有技术上的可能性。

解释复杂的算法决策系统的功能及其在特定情况下的基本原理在技术上具有挑战性。解释可能仅对数据主体提供很少的有意义信息。而且,共享算法可能导致泄露商业机密、侵犯他人的权利和自由(例如隐私) 。此外,要求每个AI系统提供解释性可能因成本过于昂贵而导致无法落实。

解释应当至少回答以下问题的其中一个:第一,决定的主要因素是什么?第二,改变某个因素是否会改变决定?第三,为什么两个外观相似的输入会得到不同的决定?为回答这三个问题,可以通过局部解释(local explanation)(对特定决策而非对系统整体行为的解释)与反事实忠诚(counterfactual faithfulness)(使得解释具备因果性的而非仅具备相关性)来实现。

如果一个人被告知他们的收入是拒绝贷款的决定性因素,那么如果他们的收入增加,他们可能会合理地期望系统现在会认为他们值得获得贷款。以上两个属性可以在不清楚AI系统细节的基础上满足解释的需要,这极大减少了商业公司对于商业秘密泄露问题的担忧。

人工智能的歧视

“ImageNet Roulette”是一个名为“训练人类”(Training Humans)的艺术展创建的网站。人们只需向其上传一张人像照片,该工具会运行一些常见的机器学习软件,然后返回决定适用于你的标签。然而,很多人在上传照片后发现,该人工智能系统经常很怪异、刻薄,充满着种族主义和对女性的嫌恶。例如,一位白金发色的白种女人的头发被标签为“人为上色”的头发,英国首相鲍里斯·约翰逊被标记为一个“蛊惑民心的政客”。

美国密歇根州前州长Rick Snyder于2013年决定安装一个价值4,700万美元的,可用于整个州的自动化决策系统——Michigan Integrated Data Automated System(MiDAS)。安装该系统的原因主要是为了削减福利开支,同时有了该系统,也可以不再继续聘用欺诈检测部门的工作人员。由于人工智能歧视的存在,导致其错误地对申请人士进行了欺诈指控。

数据的不准确、算法模型的主观选择以及机器学习的“黑盒”性质,都可能会导致人工智能最终产出的结果并非客观。 因此,一旦这种细微的歧视在某一个环节出现,其可能产生连锁反应,进而导致人工智能不断地强化和固化该种歧视,造成危害。

从现有规范的角度来看,欧盟的《可信赖人工智能伦理指南》中提到了保障公平、保持透明原则,要求人工智能具有可追溯性,提供组织化的决策过程、系统设计选择的理由以及相应的应用理由。

国家新一代人工智能治理专业委员会发布《新一代人工智能治理原则——发展负责任的人工智能》也提及了公平公正这一原则,要求在数据获取、算法设计、技术开发、产品研发和应用过程中消除偏见和歧视。在企业方面,IBM和微软也都将透明性作为其开发人工智能的原则之一。

人机交互过程中的隐私

人工智能由于具备感知新信息进而可以同人类交互的特点,人类也会就某些特定的事物同人工智能进行大量交互。在此过程中,人工智能会对数据会有一定量的积累,并不断加以分析和学习,最终对所交互的人类产生判断。

人工智能由于“黑盒”特性,可能自发的从与使用者交互过程中所获取的信息推导出与使用者相关联人士的信息,或者在与其他使用者交互过程中主披露这些信息,而这些信息可能并非是使用者在使用前所同意人工智能去掌握或披露的信息。

联邦学习(Federated Learning)

“联邦学习” 或许在现阶段为我们提供了一种既能保护数据隐私同时也能为人工智能打破数据屏障的思路。

联邦学习由谷歌在2016年提出,效果是在不共享隐私数据的情况下,通过分散学习的计算参与到各方的数据库上进行加密的分布式计算以进行协同的训练。

以人工智能零售业为例,其目的是利用机器学习技术为用户带来个性化的产品服务,会涉及到的数据特征主要包含用户购买能力、用户个人偏好及产品特点三部分。而实际应用之中,这三种数据特征可能分散在银行、社交网站和购物网站。鉴于这三方之间的数据壁垒较难被打破,联邦学习的出现使得我们无须进行数据的交换或导出就可以联合多个实体构建人工智能学习模型,解决了上述数据壁垒的问题,也同时保护了数据隐私的安全。

就人工智能在交互过程数据的收集和使用进行规制,从而减少使用者所需进行同意的范围与内容;加强对于人工智能在交互者同意其掌握、披露的信息中推导行为的规制,以保护授权范围外的隐私信息不被掌握;在不同行业制定符合行业特性的相应规范。